Calcolo ad alte prestazioni

SUPERCOMPUTING

SUPERCOMPUTING

EUROfusion: ENEA e CINECA forniranno servizi di calcolo ad alte prestazioni e storage di dati, e gestiranno il supercomputer MARCONI per le analisi numeriche sulla fisica e l’ingegneria

17.09.2018

Testo dell’articolo

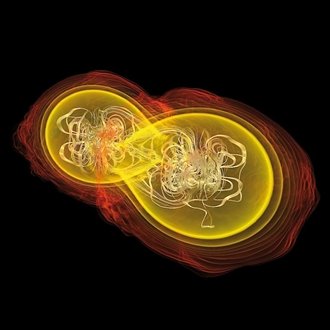

Image credit: C.S. Chang/Princeton Plasma Physics Laboratory

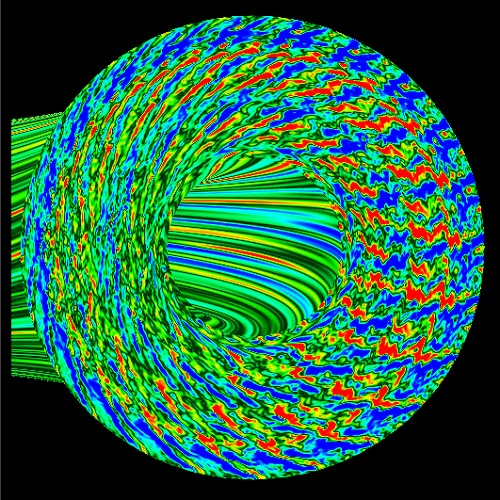

ENEA e CINECA hanno vinto una gara internazionale per realizzare in Italia un supercomputer di ultima generazione per la ricerca europea sulla fusione nucleare, in grado di eseguire 8 milioni di miliardi di operazioni al secondo (8 Pflops) e dotato di processori di ultima generazione. A partire dal 2019 e per cinque anni, i due enti italiani forniranno servizi di calcolo ad alte prestazioni o HPC (High Performance Computing) e storage di dati per EUROfusion, il consorzio europeo per lo sviluppo dell’energia da fusione e gestiranno il supercalcolatore installato presso il centro di calcolo del CINECA per la simulazione numerica della fisica dei plasmi termonucleari e l’analisi strutturale dei materiali avanzati per applicazioni energetiche.

Image credit: CINECA/Flickr

ENEA, referente del progetto e membro di EUROfusion, provvederà alla gestione dei servizi HPC e di supporto applicativo agli utenti del consorzio, mentre CINECA metterà a disposizione il supercalcolatore, una partizione del principale computer di ricerca italiano MARCONI, con una potenza di picco di 16 Pflops. Con una potenza di calcolo quasi raddoppiata rispetto alla precedente versione, il supercomputer offrirà servizi essenziali per la ricerca sulla fusione, oltre che per la modellistica computazionale del plasma e dei materiali, anche per la validazione dei risultati sperimentali di ITER, il grande progetto internazionale che dovrà dimostrare la fattibilità dello sfruttamento dell’energia da fusione, e come base per la progettazione di DEMO, il reattore che dopo il 2050 dovrà immettere energia elettrica da fusione in rete.

Il progetto, finanziato da EUROfusion, sarà di supporto anche a DTT (Divertor Tokamak Test), il polo di eccellenza internazionale per la ricerca sulla fusione nucleare che sorgerà all’interno del Centro ENEA di Frascati per fornire risposte scientifiche, tecniche e tecnologiche cruciali nel settore e ricadute di grande rilievo. Ideato dall’ENEA in collaborazione con Consorzio RFX, CNR, INFN, CREATE e molti tra i più prestigiosi atenei italiani, DTT vedrà coinvolte oltre 1.500 persone.

Testo redatto su fonte CINECA del 14 settembre 2018

Per approfondimenti su MARCONI: www.cineca.it/it/content/marconi

Image credit: G. Kerbel of the Numerical Tokamak Project

© Copyright ADEPRON – Riproduzione riservata

SUPERCOMPUTING

SUPERCOMPUTING

Ricercatori di tutto il mondo puntano, al prossimo salto nella capacità di elaborazione, ai “computer alla esascala”, ma le sfide tecnologiche che devono superare sono ardue

03.12.2017

Testo dell’articolo

Summit è progettato per funzionare a una velocità di picco di 200 petaFLOPS (1 petaFLOPS = 10^15 FLoating point Operations Per Second), cioè è in grado di effettuare fino a 200 milioni di miliardi di “operazioni in virgola mobile” al secondo. Questo renderebbe Summit più veloce del 60 per cento rispetto all’attuale primatista mondiale cinese. Per molti informatici, il completamento di Summit è solo una fase di un processo molto più grande.

In tutto il mondo, gruppi di ingegneri e scienziati puntano al prossimo salto nella capacità di elaborazione: i computer a “esascala”, supercomputer in grado di elaborare un insieme specifico di equazioni di algebra lineare alla velocità equivalente di 1 exaFLOPS, pari a 1.000 petaFLOPS (10^18 FLOPS, 1 miliardo di miliardi di “operazioni in virgola mobile” al secondo) o più. Un gruppo di ricercatori ha usato questo valore di riferimento, chiamato LINPACK, per redigere fin dal 1993 la classifica dei supercomputer Top500.

Già quattro gruppi nazionali o internazionali, in collaborazione con le industrie informatiche delle loro regioni geografiche, stanno lavorando per raggiungere questo ambizioso obiettivo. La Cina prevede di far funzionare la sua prima macchina a esascala entro il 2020. Gli Stati Uniti, con l’Exascale Computing Project (ECP) del DOE, puntano a costruirne almeno una entro il 2021. E ci si aspetta che Unione Europea e Giappone seguano a ruota.

I ricercatori prevedono che i computer a esascala consentiranno di risolvere problemi che oggi non è possibile affrontare in campi diversi come la climatologia, le energie rinnovabili, la genomica, la geofisica e l’intelligenza artificiale. Si potrebbero associare tra loro modelli dettagliati di chimica dei carburanti e modelli di motori a combustione interna, per individuare con più rapidità i miglioramenti che potrebbero ridurre le emissioni di gas serra. Oppure si potrebbe simulare il clima globale con una risoluzione spaziale di 1 km.

Ma raggiungere il regime dell’esascala è una sfida tecnologica incredibilmente ardua. Gli aumenti esponenziali delle prestazioni di calcolo e di efficienza energetica che in passato accompagnavano la legge di Moore non sono più garantiti, e per continuare a migliorare sono necessari cambiamenti sostanziali ai componenti dei supercomputer. Inoltre, un supercomputer che si comporta bene in un test di velocità non necessariamente eccellerà nelle applicazioni scientifiche. Lo sforzo per portare il calcolo ad alte prestazioni al livello successivo sta obbligando a trasformare il modo in cui sono progettati i supercomputer e sono misurate le loro prestazioni.

HARDWARE ACCELERATO

Le tendenze generali del settore informatico stanno definendo il cammino dei computer a esascala. Per oltre un decennio, i transistor sono stati impacchettati così densamente che è impossibile far funzionare i microprocessori a ritmi ancora più veloci. Per aggirare il problema, i supercomputer di oggi si affidano pesantemente al calcolo parallelo, usando banchi di chip per creare macchine con milioni di unità di elaborazione chiamate core. Un supercomputer può essere reso più potente mettendo insieme un numero ancora maggiore di queste unità.

Ma via via che queste macchine diventano più grandi, la gestione dei dati diventa più difficile. Spostare dati dentro e fuori la memoria di massa e persino all’interno dei core richiede molta più energia dei calcoli stessi. Secondo alcune stime, fino al 90% del consumo di energia di un computer ad alte prestazioni è usato per il trasporto dei dati.

Negli ultimi anni una serie di nuove tecnologie ha contribuito a ridurre il consumo di energia. Un progresso cruciale è stato portare la memoria più vicina ai core di elaborazione per ridurre la distanza che devono percorrere i dati. Per ragioni simili, gli ingegneri hanno anche impilato in senso verticale schiere di memoria ad alte prestazioni anziché distribuirle su due dimensioni.

I supercomputer stanno inoltre integrando sempre più la memoria flash, che non richiede energia per conservare i dati, come fanno invece altri tipi di memoria molto usati. E i progettisti di circuiti hanno reso possibile disattivare i circuiti nei chip quando non sono in uso, o cambiarne tensione o frequenza per risparmiare energia.

Anche cambiamenti ancora più radicali sui processori hanno fatto la differenza. Uno dei principali sviluppi è stata l’adozione di versioni di unità di elaborazione grafica (GPU) a scopo generico, che eccellono nel tipo di elaborazione ad alta intensità di dati necessaria per applicazioni come il rendering dei videogiochi. I computer che incorporano le GPU, insieme alle unità di elaborazione centrale (CPU) per “dirigere il traffico”, sono particolarmente adatti alle simulazioni fisiche.

Altri supercomputer sono stati costruiti con processori “leggeri”, che sacrificano alcune funzioni in favore della velocità e dell’efficienza energetica.

L’obiettivo del DOE per l’uso dell’elettricità del suo primo sistema a esascala, chiamato Aurora, è di 40 MW, con un margine fino a un massimo assoluto di 60 MW. I dettagli su come l’obiettivo sarà raggiunto non sono ancora pubblici, ma si sta lavorando a una nuova piattaforma, che integra una nuova microarchitettura di chip, progettata per ridurre al minimo l’uso di energia.

La velocità di un computer nell’effettuare specifiche operazioni di algebra lineare non riflette però necessariamente la sua capacità di prevedere l’attività di un farmaco, addestrare reti neurali o eseguire simulazioni complesse. Tutti questi compiti richiedono requisiti diversi tra loro in termini di potenza di elaborazione, di quali tipi di calcoli possono essere affrontati in parallelo e di quanti dati devono essere spostati.

Negli Stati Uniti, la crescente preoccupazione per questo scollamento tra velocità di punta e utilità ha portato a una definizione di calcolo a esascala diversa, basata sulle applicazioni. Il DOE punta a fare in modo che i suoi primi computer a esascala abbiano prestazioni circa 50 volte migliori del più veloce sistema attuale degli Stati Uniti: il Titan da 17,6-petaFLOPS (misurato in LINPACK).

Per ottenere questi vantaggi, il DOE ha creato 25 gruppi di ricerca, ciascuno incaricato di realizzare un software in grado di sfruttare una macchina a esascala per risolvere uno specifico problema scientifico o ingegneristico, come la progettazione di un motore.

I ricercatori stanno considerando quello che nei prossimi decenni sarà necessario per superare l’esascala e realizzare supercomputer ancora più veloci e con migliori prestazioni. Produrre la prossima generazione di supercomputer potrebbe significare adottare tecnologie che attualmente sono ancora nelle loro primissime fasi di sviluppo: circuiti neuromorfici, forse, che sono modellati sul funzionamento dei neuroni nel cervello, o il calcolo quantistico.

Testo redatto su fonte Le Scienze del 2 dicembre 2017. Le Scienze ha curato la traduzione e l’editing dell’articolo originale:

Supercomputing poised for a massive speed boost – Nature | 29.11.2017

Per approfondimenti: Exascale Computing Project (ECP)

Image credit: Li Xiang Xinhua News Agency/Newscom

© Copyright ADEPRON – Riproduzione riservata

CHIMICA COMPUTAZIONALE

CHIMICA COMPUTAZIONALE

ENEA: un importante risultato del supercomputer CRESCO rende possibile lo studio del comportamento di proteine e meccanismi cellulari alla base della formazione dei tumori

25.03.2016

Testo dell’articolo

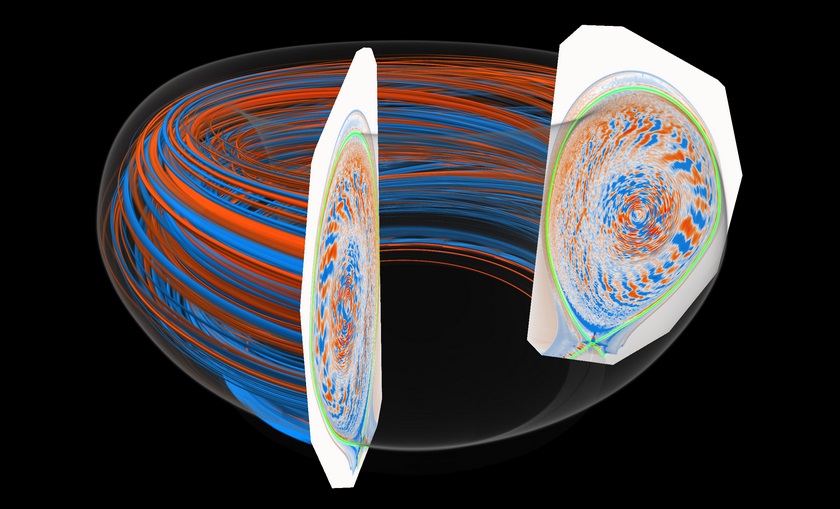

Condotto da ricercatori di ENEA, Università di Salerno, Istituto Nazionale per la Ricerca sul Cancro di Genova e Tohoku University di Sendai (Giappone), lo studio, è stato pubblicato sul “Journal of Chemical Theory and Computation” nell’articolo “Self-Assembly of Triton X-100 in Water Solutions: A Multiscale Simulation Study Linking Mesoscale to Atomistic Models“.

Il risultato ottenuto è di notevole rilevanza scientifica perché si è riusciti a progettare un sistema che “mima” le architetture molecolari e ci permetterà di comprendere meglio il corpo umano. Fino ad ora non erano disponibili strumenti che permettessero la progettazione al computer di questa classe di molecole e la loro funzionalizzazione per applicazioni biomediche. Conoscere esattamente la struttura e il meccanismo di azione di queste molecole è fondamentale per la medicina e oggi, grazie a questa infrastruttura computazionale, lo studio di nuovi approcci sperimentali e l’interpretazione dei meccanismi che inducono l’insorgenza dei tumori diventerà sempre più efficiente ed economico. L’infrastruttura computazionale, realizzata con il supporto della Divisione Sviluppo Sistemi per l’Informatica e l’ICT dell’ENEA, potrà essere utilizzata anche per studiare il comportamento delle integrine, particolari proteine che ricoprono un ruolo chiave in diversi processi cellulari come quelli metastatici dei tumori.

Con l’intelligenza artificiale e l’elaborazione delle banche dati realizzata dal supercomputer CRESCO, è possibile identificare i composti potenzialmente più interessanti per l’industria e per altre applicazioni come la biomedicina. L’evoluzione delle conoscenze scientifiche e delle tecnologie informatiche, permette inoltre di individuare nuovi protocolli di attività e progettazione, nonché di velocizzare i tempi della sperimentazione riducendo i costi della ricerca e quelli di produzione.

Più in generale, grazie ai progressi nella ricerca sulla modellistica molecolare, che comprende tutti i metodi teorici e computazionali utilizzati per rappresentare il comportamento atomico di materiali e molecole complesse, si stanno aprendo nuovi orizzonti applicativi, oltre che nella biomedicina, anche nei settori della produzione e utilizzo dell’energia, nella microelettronica, nella componentistica strutturale e nella progettazione di nuovi farmaci (drug design).

Testo redatto su fonte ENEA del 24 marzo 2016

Per approfondimenti: Self-Assembly of Triton X-100 in Water Solutions: A Multiscale Simulation Study Linking Mesoscale to Atomistic Models – Journal of Chemical Theory and Computation | 18.08.2015

Image credit: Vincent H. Crespi/Pennsylvania State University

© Copyright ADEPRON – Riproduzione riservata

SUPERCOMPUTING

SUPERCOMPUTING

Parte ExaNeSt, un progetto UE per lo sviluppo di un sistema High Performance Computing con una potenza di calcolo di un miliardo di miliardi (10^18) di operazioni al secondo

16.12.2015

Testo dell’articolo

Obiettivo del progetto è realizzare un prototipo con processori, tra centomila e un milione, che siano in grado, da un lato di archiviare e accedere ai dati del calcolo nel minor tempo possibile e, dall’altro, di parlare tra loro in modo efficiente, e con il minimo dispendio energetico. Lo sviluppo di ExaNeSt è fondamentale per testare programmi per calcoli di fisica teorica computazionale o simulazioni di sistemi complessi, tra i quali un modello ridotto e semplificato del funzionamento del cervello umano.

Lo studio delle reti è uno dei settori di punta in cui l’Unione Europea ha deciso d’investire maggiormente nei prossimi anni. Secondo le previsioni di Google EMEA (Europa, Medio Oriente e Africa), infatti, entro il 2020 le persone connesse alla Rete sono destinate quasi a raddoppiare, passando dagli attuali 2,8 miliardi (ciascuna con due o tre dispositivi pro capite) a 5 miliardi nei prossimi cinque anni (con l’impiego di cinque o sei dispositivi). Un balzo che richiederà anche lo sviluppo di supercomputer, sistemi costituiti appunto da centinaia di migliaia di microprocessori capaci di operare in parallelo.

Testo redatto su fonte INFN del 15 dicembre 2015

Per approfondimenti su ExaNeSt: www.exanest.eu

H2020-FETHPC-1-2014: FETHPC-1-2014 – HPC Core Technologies, Programming Environments and Algorithms for Extreme Parallelism and Extreme Data Applications

Image credit: The ExaNeSt Consortium, 2015

© Copyright ADEPRON – Riproduzione riservata

SUPERCOMPUTING

SUPERCOMPUTING

ExaHyPE: progetto di ricerca UE che propone di sviluppare entro il 2020 un software di simulazione open source capace di sfruttare la potenza degli Exascale supercomputer

23.11.2015

Testo dell’articolo

Per raggiungere questi risultati è nato ExaHyPE (An Exascale Hyperbolic PDE Engine), un progetto di ricerca, finanziato con 2,8 milioni di euro per 4 anni dalla Commissione Europea nell’ambito di Horizon 2020, che propone di sviluppare entro il 2020 un nuovo software di simulazione capace di sfruttare la potenza dei supercomputer di nuova generazione. Al progetto lavora un team di scienziati interdisciplinare e internazionale composto da 8 partner di 4 Paesi: Germania (Technische Universität München, Frankfurt Institute for Advanced Studies, Ludwig-Maximilians-Universität München, Bavarian Research Alliance, Leibniz Supercomputing Centre), Italia (Università di Trento), Regno Unito (Durham University) e Russia (RSC Technologies).

La realizzazione di applicazioni software per questo tipo di macchine è un’operazione estremamente complessa rispetto a quanto avviene invece per i calcolatori convenzionali. I ricercatori di ExaHype stanno cercando di mantenere l’algoritmo più generale e aperto possibile a future applicazioni in settori molto diversi tra loro: a tal fine i risultati del progetto saranno accessibili a tutti in open source. L’obiettivo è quello di rendere questa tecnologia adattabile e facilmente fruibile per le esigenze di ricerca più diverse nel minor tempo possibile.

Uno degli ostacoli maggiore da superare riguarderà il consumo di energia. Attualmente i supercomputer come il cinese Tianhe-2, gli statunitensi Titan e Sequoia e il giapponese K Computer sono in grado di eseguire quasi 34 milioni di miliardi di operazioni al secondo (10^15), consumando tra gli 8 e i 18 MW di energia, con un costo medio annuo di circa un milione di dollari a MW. Con le tecnologie attuali, un Exascale supercomputer per funzionare richiederebbe 70 MW, un impegno considerevole, sia sul piano finanziario, sia su quello delle infrastrutture. Ed è per questo motivo che il software di simulazione del progetto ExaHyPE sarà progettato tenendo conto delle esigenze di risparmio energetico che un hardware dovrà essere in grado di sostenere, garantendo nel contempo il miglioramento dell’efficienza in termini di performance.

Nello specifico, l’aumento della velocità di calcolo (mille volte in più rispetto a oggi) dovrà essere accompagnata da un miglioramento nei processi di trasferimento di dati e nella memorizzazione, che dovranno essere sempre più rapidi ed efficienti per consentire al supercomputer di processare correttamente le informazioni senza sprecare energia. Un’altra importante sfida è poi quella della comunicazione interna all’hardware: in questa direzione il progetto prevede di mettere a punto un algoritmo scalabile che aumenta in modo dinamico e auto-adattativo la risoluzione delle simulazioni, solo quando serve. In tal modo sarà possibile ottenere simulazioni molto accurate, riducendo però al minimo le operazioni necessarie, risparmiando così energia e memoria.

Testo redatto su fonte Università di Trento dell’11 novembre 2015

Per approfondimenti su ExaHyPE: exahype.eu

Image credit: L. Rezzolla (AEI) & M. Koppitz (AEI/ZIB)

© Copyright ADEPRON – Riproduzione riservata

SUPERCOMPUTING

SUPERCOMPUTING

Al CINECA di Bologna entra in funzione Galileo, il nuovo sistema per il Calcolo ad Alte Prestazioni in grado di eseguire un milione di miliardi di operazioni al secondo

06.05.2015

Testo dell’articolo

Nel dettaglio, Galileo è un calcolatore IBM/Lenovo Nextscale configurato con 516 nodi per un totale di 8.256 processori Intel Haswell, 768 acceleratori floating point Intel Phi e 80 acceleratori floating point nVidia K80, 1 PetaByte di spazio disco, in grado di esprimere una potenza computazionale di picco di oltre 1 PetaFlop/s (un milione di miliardi di operazioni al secondo).

Grazie a questo nuovo sistema sarà possibile risolvere problemi scientifici d’interesse per le più attuali ricerche, e anche affinare strategie e programmi di calcolo che potranno poi essere supportati a livello internazionale per avere accesso ai più potenti centri europei di supercalcolo, come PRACE, l’infrastruttura di ricerca in ambito supercalcolo, finanziata dalla Commissione Europea.

Secondo Raffaele Tripiccione, che coordina le attività di Fisica Computazionale in ambito INFN, Galileo darà un contributo significativo alle attività di ricerca in Fisica Teorica Computazionale dell’INFN, fornendo strumenti di calcolo adeguati a supportare gli ambiziosi programmi scientifici in corso in aree di punta della fisica delle interazioni fondamentali e della fisica dei sistemi complessi.

Testo redatto su fonte INFN del 23 aprile 2015

Image credit: CINECA/SCAI

© Copyright ADEPRON – Riproduzione riservata

QUANTUM COMPUTING

QUANTUM COMPUTING

Proposto un nuovo meccanismo per la computazione quantistica: l’obiettivo è manipolare in modo controllato gli elementi di memoria del futuro computer quantico

06.12.2014

Testo dell’articolo

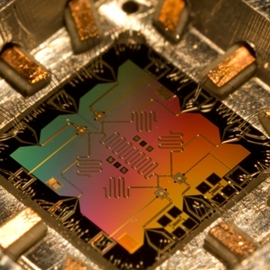

L’idea alla base della proposta teorica del lavoro in questione consiste nell’utilizzare il cosiddetto effetto Zenone quantistico per manipolare in modo controllato gli elementi di memoria del computer quantico. In base ai principi della Meccanica Quantistica in effetti è noto come il mero processo di osservazione di un sistema fisico possa in principio modificarne la dinamica. Nel caso dell’effetto Zenone, tale osservazione viene ripetuta in maniera frequente in modo tale da congelare alcuni gradi di libertà del sistema di interesse impedendo che essi evolvano nel tempo. Questo induce un confinamento efficace della memoria quantistica all’interno di un certo spazio di stati accessibili. Nel lavoro pubblicato su Nature Communication, “Exponential rise of dynamical complexity in quantum computing through projections”, Vittorio Giovannetti ed i suoi collaboratori mostrano come l’intero processo possa essere controllato esternamente in modo da forzare il sistema a compiere certe operazioni fondamentali che possono poi essere utilizzate per programmare il computer quantistico.

Testo redatto su fonte Scuola Normale Superiore di Pisa del 5 dicembre 2014

Per approfondimenti: Exponential rise of dynamical complexity in quantum computing through projections – Nature Communications | 10.10.2014

Image credit: UCSB/Erik Lucero

© Copyright ADEPRON – Riproduzione riservata

SUPERCOMPUTING

SUPERCOMPUTING

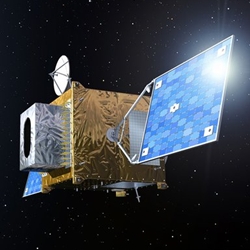

Un supercomputer “made in Italy”, fornirà alle nuove generazioni di satelliti meteorologici una capacità di calcolo tale da interpretare in autonomia ciò che osservano

26.11.2014

Testo dell’articolo

Con questo obiettivo, negli ultimi anni un team di ricercatori coordinato dal Prof. Massimo Violante del Dipartimento di Automatica e Informatica del Politecnico di Torino ha collaborato ad un progetto per la realizzazione di un supercomputer che potesse operare nello spazio, superando i limiti della tecnologia attualmente impiegata nella maggior parte delle missioni spaziali. Al progetto partecipano Thales Alenia Space Italia (coordinatore), il Politecnico di Torino, l’European Space Agency (ESA), l’Istituto Nazionale di Astrofisica (INAF), l’Università di Tor Vergata e Sanitas Eg.

Il nuovo supercomputer troverà il suo primo utilizzo su 4 dei 6 satelliti che costituiranno il Meteosat Third Generation (MTG), il sistema di satelliti metereologici europei di ultima generazione che verrà realizzato in cooperazione tra EUMETSAT ed ESA, e il cui primo lancio per la messa in orbita è previsto per il 2018. Il computer che volerà nello spazio lavorerà all’identificazione ed alla classificazione dei fulmini, permettendo di mappare le zone temporalesche ad alto rischio e fornendo quindi informazioni fondamentali per migliorare la sicurezza del traffico aereo. Il supercalcolatore avrà un “cuore” nato a Torino. Il team di ricercatori coordinato dal Prof. Massimo Violante ha infatti svolto un ruolo chiave nella scelta della CPU, ovvero il componente principale del computer, ed ha contribuito alla definizione dell’architettura generale della macchina con particolare attenzione alle tecniche per la gestione dei potenziali guasti prodotti dalla radiazione spaziale, oltre a collaborare alla validazione dell’intero computer.

Il risultato del progetto sarà il primo supercomputer di concezione totalmente europea qualificato per impieghi spaziali, che supererà di due ordini di grandezza le prestazioni dei computer oggi impiegati in analoghe missioni. Grazie al nuovo calcolatore sarà quindi possibile dotare le prossime generazioni di satelliti di una potenza di calcolo totalmente made-in-Italy che permetterà di realizzare nello spazio operazioni complesse che prima potevano essere effettuate solo sulla terra. Grazie a questa capacità di calcolo sarà quindi possibile analizzare i dati nel momento stesso in cui sono raccolti, rendendo possibili applicazioni prima impensabili. >

Testo redatto su fonte Politecnico di Torino del 25 novembre 2014

Per approfondimenti: www.eumetsat.int

Image credit: EUMETSAT/Meteosat Third Generation, 2010

© Copyright ADEPRON – Riproduzione riservata

SUPERCOMPUTING

SUPERCOMPUTING

ENI installa un sistema di HPC da 3 Petaflops, il più potente supercomputer in Europa nell’ambito dell’esplorazione e della simulazione dei giacimenti di idrocarburi

04.07.2014

Testo dell’articolo

Con una capacità totale di calcolo di 3 Petaflops (misurati con i benchmark Linpack utilizzati per calcolare le prestazioni dei computer) ed una elevata capacità di memorizzazione pari a 7,5 Petabytes, il nuovo sistema HPC ENI – che si è classificato 11° nella nuova classifica TOP500 che elenca i maggiori calcolatori del mondo – è il più potente supercomputer in Europa destinato alla produzione industriale Oil&Gas e uno dei più grandi in tutto il settore petrolifero. La natura “ibrida” dell’architettura di calcolo garantisce una straordinaria performance in termini di efficienza energetica che con 2.8 GigaFlops/Watt colloca il sistema HPC di ENI al 9° posto della classifica Green500 dei calcolatori più efficienti. L’efficienza complessiva del sistema beneficia inoltre dell’innovativo sistema di raffreddamento dell’ENI Green Data Center (ENI GDC) che lo ospita. Il Green Data Center (GDC) di Ferrera Erbognone (Pavia) è stato realizzato per ospitare i sistemi informatici centrali di elaborazione di ENI, sia di informatica gestionale che le applicazioni Oil&Gas. Nel GDC sono impiegate le più innovative infrastrutture per il risparmio energetico che contribuiscono ad abbattere l’emissione di CO2 di 335.000 tonnellate annue (circa l’1% dell’obiettivo italiano di Kyoto per l’energia) e a ridurre notevolmente i costi operativi.

Il nuovo HPC sarà a supporto del core business dell’azienda, consentendo una più veloce e accurata elaborazione dei dati del sottosuolo. La strategia di ENI è quella di utilizzare la più moderna tecnologia di elaborazione per supportare l’esplorazione e la simulazione dei giacimenti. Utilizzando codici proprietari sviluppati dalla propria ricerca interna e combinati con i più recenti strumenti di programmazione parallela, ENI può ottenere dai dati sismici –cinque volte più rapidamente rispetto a quanto possibile con i supercomputer tradizionali – immagini 3D del sottosuolo in alta risoluzione, nonché dati di altissimo valore utili a ridurre i rischi legati alle attività di esplorazione.

Per quanto riguarda la simulazione dinamica di giacimento il nuovo sistema permette simulazioni sempre più accurate dei giacimenti di idrocarburi che servono a ricreare modelli sempre più dettagliati, oltre che a ridurre il tempo di simulazione. Questi due aspetti possono essere cruciali per l’ottimizzazione dello sviluppo dei giacimenti di idrocarburi e del time to market.

Testo redatto su fonte ENI del 3 luglio 2014

Image credit: ENI

© Copyright ADEPRON – Riproduzione riservata

SUPERCOMPUTING

SUPERCOMPUTING

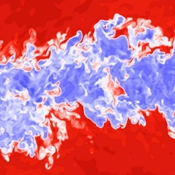

Ricercatori del Politecnico di Torino hanno utilizzato un supercomputer per studiare i fenomeni fluidodinamici turbolenti che determinano la formazione delle nubi

12.06.2014

Testo dell’articolo

Il progetto è stato segnalato da PRACE – Partnership for Advanced Computing in Europe (Associazione che raggruppa i principali centri di supercalcolo europei e ha l’obiettivo di consentire ai ricercatori l’accesso ai più avanzati sistemi di calcolo) come “success-story” ed inserita nel suo annual report 2013 pubblicato a maggio 2014 assieme ad altri sette progetti internazionali scelti tra i 103 condotti tra il 2010 ed il 2012. Il supercomputer CURIE, installato a Parigi, ha ospitato da maggio 2012 a maggio 2013 circa 3.000.000 di ore di calcolo (equivalenti a 340 anni di calcolo su una macchina singola) per il progetto interdisciplinare di studio delle turbolenze del gruppo coordinato da Daniela Tordella, docente di Fluidodinamica e composto da Michele Iovieno e Stefania Scarsoglio.

Il progetto ha anche coinvolto dottorandi e tesisti, permettendo loro di entrare a contatto con l’impiego di risorse di supercalcolo di altissimo livello: un grande asset in più per questi studenti, direttamente spendibile sul mercato del lavoro, dal momento che anche l’industria sta iniziando ad usare intensamente questo tipo di macchine di super-calcolo ed è alla ricerca di professionalità che possiedano queste competenze, come dimostra l’interesse già manifestato da varie multinazionali.

Testo redatto su fonte Politecnico di Torino del 10 giugno 2014

Image credit: PHILOFLUID

© Copyright ADEPRON – Riproduzione riservata

SUPERCOMPUTING

SUPERCOMPUTING

L’ENEA inaugura CRESCO4, il supercomputer che sarà utilizzato per applicazioni avanzate di modellistica, calcolo e simulazioni nei settori della ricerca e dell’industria

13.03.2014

Testo dell’articolo

Con CRESCO4 il centro di supercalcolo dell’ENEA di Portici, dove già erano operativi altri tre supercomputer, triplicherà la potenza di calcolo disponibile, permettendo applicazioni per attività che richiedono un’elevata capacità computazionale. Questi quattro supercomputer, integrati in un’unica infrastruttura per il calcolo distribuito, denominata ENEAGRID, e connessi tra loro dalla rete GARR, sono in grado di offrire una potenza computazionale aggregata di circa 150 Teraflops.

Il centro di supercalcolo di Portici supporta già diverse applicazioni di ricerca numerica, quali la scienza dei materiali, la dinamica molecolare, la climatologia, la fluidodinamica computazionale, il nucleare. Si citano, fra l’altro, gli studi per la ricostruzione ad alta risoluzione delle variazioni climatiche del Bacino del Mediterraneo negli ultimi 46 anni, lo studio della dispersione di Iodio-131 dopo l’incidente nucleare di Fukushima e l’ottimizzazione di processi di combustione sviluppati con codici ENEA. L’ENEA, grazie alla maggiore potenza di calcolo ora disponibile, si pone l’obiettivo di continuare ad essere un punto di riferimento per la comunità scientifica ed industriale a livello nazionale ed europeo.

Per presentare il quadro internazionale e le prospettive di sviluppo nel settore ICT è intervenuto alla manifestazione Jack Dongarra, docente di computer science all’University Tennessee, che è anche uno dei fondatori della Top500, la classifica mondiale dei supercomputer. Con la sua relazione, Inmaculada Leyva, docente presso il Centro per le tecnologie Biomediche dell’Università Rey Juan Carlos di Madrid, ha sottolineato come le infrastrutture ICT di elevata qualità siano il motore di prestigiose collaborazioni di ricerca internazionale.

Testo redatto su fonte ENEA del 12 marzo 2014

Image credit: ENEA

© Copyright ADEPRON – Riproduzione riservata

NEUROINFORMATICA

NEUROINFORMATICA

“Human Brain Project”: il progetto di ricerca finanziato dalla UE con 1,2 miliardi di euro per simulare con un supercomputer l’intero cervello umano entro il 2020

04.06.2013

Testo dell’articolo

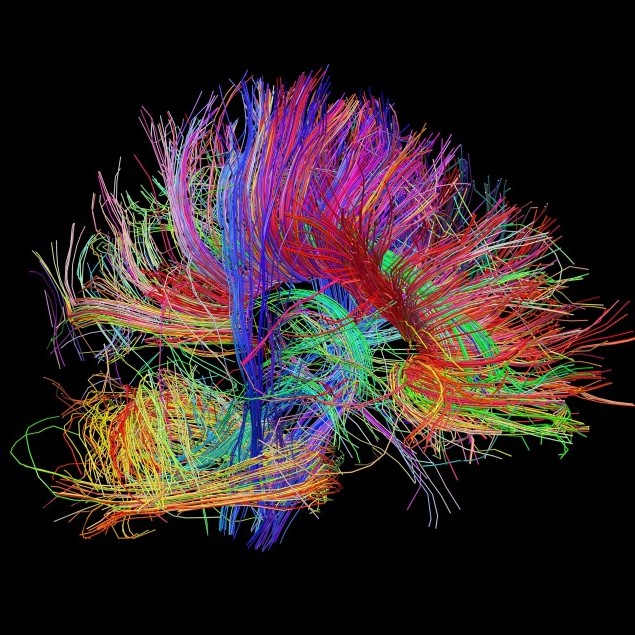

L’obiettivo finale è ambizioso: consentire ai neuroscienziati di ricostruire il percorso che dalle molecole, dai geni e dalle cellule conduce all’intelligenza e al comportamento umano. HBP intende fornire nuovi strumenti per comprendere il cervello nei suoi meccanismi fondamentali e applicare le nuove conoscenze alla medicina e all’informatica del futuro.

Il progetto si è aggiudicato da parte della Commissione Europea un finanziamento complessivo di circa 1,2 miliardi di euro in dieci anni, dei quali 54 milioni di euro per 30 mesi copriranno la fase di lancio. Al progetto – coordinato dal neuroscienziato Henry Markram dell’Ecole Polytechnique Fédérale di Losanna – partecipano 87 istituti di ricerca di 24 paesi del mondo. Di essi cinque sono italiani: il Laboratorio Europeo di Spettroscopia Non lineare dell’Università di Firenze (LENS/UNIFI), il Politecnico di Torino (POLITO), l’Università di Pavia (UNIPV), l’Istituto di Ricovero e Cura a Carattere Scientifico Fatebenefratelli (IRCCS Fatebenefratelli) di Brescia e il Consorzio Interuniversitario CINECA, il maggior centro di supercalcolo in Italia.

Le tecnologie informatiche (ICT) sono al centro del progetto: i dati clinici, raccolti da tutto il mondo, su innovative piattaforme bioinformatiche, permetteranno ai ricercatori di decifrare le informazioni più utili dal punto di vista clinico e inserirle in un modello virtuale delle malattie. L’obiettivo è costruire un simulatore dell’intera attività del cervello umano, un modello con cento miliardi di neuroni che consentirebbe di comprendere malattie neurodegenerative e altri disturbi del sistema nervoso (Alzheimer, Parkinson, epilessia e schizofrenia), per sviluppare tecniche per una diagnosi oggettiva delle affezioni del cervello, comprendere i meccanismi ad esse sottesi e mettere a punto efficaci terapie e nuovi farmaci.

Il compito dei partner italiani sarà quello di realizzare le immagini tridimensionali del cervello (LENS/UNIFI), immagazzinarle in un grosso computer per processarle a distanza (CINECA), simulare il funzionamento delle connessioni celebrali (UNIPV), trattare una grossa quantità di dati clinici e medici (IRCCS Fatebenefratelli) e realizzare strutture elettroniche che simulino i neuroni (POLITO).

La ricerca tuttavia non punta solo a simulare il funzionamento del cervello, ma si propone anche di creare una visione unitaria di questo organo così complesso. Connettendo fra di loro le conoscenze neurologiche sul funzionamento delle molecole celebrali, delle cellule e dei i circuiti neuronali con quelle sui più potenti database attualmente sviluppati grazie alle tecnologie ICT, si può arrivare a costruire un simulatore biologicamente molto dettagliato dell’intera attività del cervello umano, ma anche a porre le basi per la creazione delle nuove generazioni di supercomputer intelligenti, e mettere tutto questo a disposizione della comunità scientifica internazionale. (Redazione)

Per approfondimenti: www.humanbrainproject.eu

© Copyright ADEPRON – Riproduzione riservata

SUPERCOMPUTING

SUPERCOMPUTING

AURORA, il supercomputer italiano del CINECA, balza al primo posto nella classifica mondiale “Green500” per efficienza energetica in ambito data center

17.05.2013

Testo dell’articolo

A disposizione dei membri del Partnership for Advanced Computing in Europe (PRACE) e dei principali enti di ricerca italiani, Eurora permetterà agli scienziati di condurre i loro studi più rapidamente e arrivare a nuove scoperte in un ampio raggio di discipline, tra cui la scienza dei materiali, l’astrofisica, le scienze della vita e le scienze della Terra.

“Le avanzate simulazioni computerizzate, che consentono agli scienziati di scoprire nuovi fenomeni e verificare le loro ipotesi, richiedono un’enorme potenza di calcolo, che può comportare elevati consumi energetici”, ha dichiarato Sanzio Bassini, direttore del dipartimento HPC del CINECA, che ha poi concluso: “Equipaggiato con l’ultra-efficiente sistema Aurora e con gli acceleratori GPU NVIDIA, Eurora offrirà ai ricercatori europei le risorse di calcolo necessarie per studiare sistemi fisici e biologici di ogni tipo e al contempo ci permetterà di mantenere il consumo energetico del data center e i relativi costi sotto controllo.”

Combinando le tecnologie delle GPU NVIDIA Tesla K20 con la tecnologia Aurora Hot Water Cooling di Eurotech, il sistema Eurora è più efficiente e compatto rispetto alle soluzioni tradizionali raffreddate ad aria. Sistemi HPC basati su architettura hardware Eurora, tra cui l’Aurora Eurotech Tigon, consentono potenzialmente di ridurre le bollette energetiche dei data center fino al 50% e ridurre il costo totale di proprietà (TCO) del 30-50%. Inoltre, l’utilizzo della tecnologia of Aurora Hot Water Cooling riduce o elimina la necessità di condizionamento in climi tipicamente caldi come quello italiano. L’energia termica prodotta dal sistema, infatti, può essere utilizzato per il riscaldamento di edifici, per il condizionamento o per la tri-generazione, la produzione combinata di elettricità, riscaldamento e raffreddamento.

“Gli Acceleratori GPU sono dal punto di vista energetico intrinsecamente più efficienti delle CPU, e gli acceleratori Tesla K20 ampliano considerevolmente questo divario”, ha dichiarato Sumit Gupta, General Manger della Tesla accelerated computing business di NVIDIA, che ha poi proseguito: “L’efficienza energetica è diventata l’elemento determinante della potenza di calcolo. Le GPU consentono ai sistemi dei data center di ogni dimensione – dai piccoli cluster ai futuri sistemi di classe-exascale- di raggiungere i loro obiettivi in termini di performance rimanendo all’interno di bilanci energetici sostenibili.”

Eurora è un “sistema prototipo” sviluppato per CINECA nell’ambito dell’iniziativa PRACE 2IP, volta a fornire infrastrutture di alta qualità e sostenibili per soddisfare le esigenze della comunità europea di utenti dell’HPC.

Per approfondimenti: www.cineca.it e www.green500.org

© Copyright ADEPRON – Riproduzione riservata